Science Friction

Zucks grosser Bluff

Vor zwei Jahren hatte Facebook eine wissenschaftliche Aufarbeitung des Cambridge-Analytica-Skandals versprochen. Seitdem sorgt das Projekt für viel Frust und Unmut. Geldgeber wenden sich ab, beteiligte Forscher fühlen sich verschaukelt, vermuten hinter der Aktion gar einen PR-Schwindel.

Hat Facebook US-Präsident Trump zum Wahlsieg verholfen? Diese Frage wird sich wohl nie mehr beantworten lassen. Facebook zeigt wenig Interesse, eine seriöse und unabhängige Aufklärung in dieser Sache zuzulassen. Begründet wird das von dem skandalgeplagten Internet-Konzern – ausgerechnet – mit dem Verweis auf Datenschutz.

Eine Gruppe internationaler Wissenschaftler sollte Einblick in die Facebook-Daten erhalten. Doch seit Beginn des Projektes gibt es nur Ärger: Deadlines werden nicht eingehalten, Datensätze nicht geliefert. Und wenn irgendwann doch was kommt, dann sind die Daten fehlerhaft oder in einer Form, mit der die beteiligten Wissenschaftler offenbar nur wenig anfangen können.

Worum geht es?

Im April 2018 wurde Facebook-Chef Mark Zuckerberg nach Washington einbestellt, wo er vor dem US-Kongress aussagen sollte. Es ging um den Cambridge-Analytica-Skandal, bei dem private Daten von zig-Millionen Facebook-Nutzern an ein Privatunternehmen flossen, die dann später u.a. im Wahlkampf von Donald Trump eingesetzt wurden.

Bei jener zweitägigen Anhörung gelobte Zuckerberg Besserung. Mehr noch: Er versprach den Kongressabgeordneten eine externe, von Facebook unabhängige wissenschaftliche Untersuchung.

Kern dieser Maßnahme ist ein Projekt, zu dem Facebook handverlesene Wissenschaftler aus der ganzen Welt eingeladen hatte. Die Forscher sollten der Frage nachgehen, wie sich Fake News, staatlich gelenkte Propaganda aber auch Hassbotschaften via Facebook verbreiten und inwieweit das Auswirkungen auf Wahlen haben könnte. Zwölf Forschungsteams wurden ausgewählt, die Einblick in den Heiligen Gral erhalten sollten: den gesammelten Datenschatz von Facebook.

Untragbar, inakzeptabel, verheerend!

Mehr als ein Jahr war vergangen, da wurden im Sommer 2019 alle Teams ins Hauptquartier nach Menlo Park eingeladen. Dort erfolgte eine Einweisung in das neu entwickelte Recherche-Tool von Facebook. Eine API-Schnittstelle für die Wissenschaftler, wie das noch in der Zeit vor Cambridge-Analytica üblich war, gab es nicht mehr. Stattdessen wurde jetzt auf dem Facebook-Server selbst eine Art Leseraum errichtet, in dem die Forscher virtuell ihre Arbeit verrichten dürfen.

Das Problem: Die Bibliothek war zu diesem Zeitpunkt noch immer leer. Weitere 6 Monate vergingen, doch die lange angekündigten Datensätze kamen einfach nicht. Die erste von den Wissenschaftlern gesetzte Deadline verstrich. Dann die nächste. Fast zwei Jahre nach Zuckerbergs Auftritt vor dem US-Kongress waren inzwischen vergangen. Zum Valentinstag 2020 war der erste Datensatz abrufbar, versehen mit dem Hinweis, dass die Daten Fehler enthielten, die erst noch gefixt werden müssten.

Die Situation sei „unhaltbar“ und „inakzeptabel“ formulierten die Wissenschaftler bereits Ende 2019 in einer öffentlichen Erklärung. Ungewöhnlich klare Worte für Wissenschaftler, eine Berufsgruppe, die sonst eher für ihre verklausulierte Sprache und ihr Fachchinesisch bekannt ist. Projektpläne laufen aus, die bewilligten Gelder sind aufgebraucht noch bevor die eigentliche Recherche beginnen konnte. Die Stimmung unter den Teilnehmern ist gereizt.

Spielt Facebook auf Zeit?

Der Verdacht kommt auf: Spielt Facebook auf Zeit? Zwar hat der Konzern den Wissenschaftlern völlige Freiheit bei ihrer Auswertung zugesichert. Doch manche Teilnehmer argwöhnen inzwischen, dass sie von Facebook ganz bewusst hingehalten werden. Diente das Projekt von Beginn an nie der Aufklärung, sondern allein als PR-Instrument zum eigenen Whitewashing?

Aktuell laufen in den USA umfassende Ermittlungen der Wettbewerbsbehörde FTC sowie des US-Justizministeriums. Dabei geht es um eine schärfere Regulierung von Google, Amazon und Facebook. Seit einem Jahr werden sogar Forderungen nach einer Zerschlagung der Tech-Giganten laut.

Parallel dazu läuft der Wahlkampf für die bevorstehende US-Präsidentschaftswahl. Neue Erkenntnisse etwa darüber, dass der Einfluss von Facebook auf das Wahlergebnis vielleicht sogar noch größer sein könnte, als bislang angenommen, wären zu einem solchen Zeitpunkt sicherlich verheerend.

Frustrierte Forscher

Einer der deutschen Teilnehmer an dem von Facebook initiierten Forschungs-Projekt ist Simon Hegelich*, Professor für politische Datenwissenschaft an der TU München. Wie die meisten seiner internationalen Kollegen ist auch Hegelich von dem Verhalten des Konzerns enttäuscht. In einem kürzlich veröffentlichten Text im renommierten US-Fachmagazin nature erklärt er, weshalb die Daten, die Facebook nach knapp zwei Jahren nun endlich vorgelegt hat, seiner Meinung nach wenig Aussagekraft besitzen und weshalb er dahinter keinen Zufall vermutet.

Hegelich kritisiert sowohl die periodische Auswahl der Daten (ausgerechnet die spannende Zeitspanne von Brexit und des Trump-Wahlkampfs sind darin nicht enthalten), als auch den Grad der Anonymisierung. Diese sei weit höher ausgefallen, als nötig gewesen wäre, um die Identität der Nutzer zu schützen. Staatliche Zensus-Daten, nicht einmal medizinische Patientendaten würden derart verwässert, so Hegelich.

*Offenlegung: Ich bin mit Simon Hegelich befreundet

In die gleiche Kerbe schlägt auch Paul Francis, Direktor und wissenschaftlicher Direktor des Max-Planck-Instituts für Softwaresysteme in Kaiserslautern. Er stellt die gesamte Methode in Frage, mit der Facebook hier seine Daten künstlich verrauscht. “Die tun alles, um nicht noch einmal verklagt zu werden”, vermutet er. Ausgerechnet gegenüber der Wissenschaft schieße man hier offenbar weit über das Ziel hinaus.

Facebook betont auf Nachfrage, dass das Projekt bewusst in die Zukunft schaue, nicht zurück. Man verweist auf die Ankündigung von 2018:

„The focus will be entirely forward looking. And our goals are to understand Facebook’s impact on upcoming elections — like Brazil, India, Mexico and the US midterms — and to inform our future product and policy decisions.„

Der Datensatz für die Wissenschaftler endet Mitte 2019. Weshalb Facebook die Daten zum wichtigsten Wahlkampf überhaupt, zur Wahl der US-Präsidentschaft 2020 nicht freigibt, bleibt ein Rätsel und wird auf wiederholte Nachfrage auch nicht beantwortet.

Datenschutz versus Öffentliches Interesse

Bei dem Projekt galt es von Anfang an, zwei gegensätzliche Interessen in Einklang zu bringen: Auf der einen Seite ist da der Schutz der Facebook-Nutzerdaten vor Missbrauch. Klar ist: So etwas wie mit Cambridge Analytica dürfe nicht noch einmal passieren.

Dem gegenüber steht das Interesse der Forscher, möglichst unverfälschte Datensätze zu erhalten, um valide Aussagen treffen zu können. Genau das ist ja Sinn und Zweck der Operation und wurde in Ausschüssen und gegenüber der Öffentlichkeit immer wieder so verkauft.

Zur Lösung dieses Interessenkonflikts wurde zu Beginn des Projekts eine Kommission einberufen, die als Clearingstelle zwischen Facebook und den Wissenschaftlern fungiert: die Social Science One (SS1).

Dieses Gremium soll als unabhängiger Dritter die Interessen der Wissenschaftler gegenüber Facebook vertreten und festlegen, was die Forscher zu sehen bekommen und was nicht. Auf der eigenen Webseite verkauft sich die Social Science One als neutraler Mittler zwischen Industrie und Forschung:

“ (…) a new type of partnership between academic researchers and private industry to advance the goals of social science in understanding and solving society’s greatest challenges.„

Doch wie unabhängig ist diese Clearingstelle wirklich?

Vom Datenhändler zum Datenwächter?

Zusammengestellt wurde das Gremium nicht etwa von einer demokratisch legitimierten Institution, sondern von Facebook. Gary King, einer der beiden Vorsitzenden von Social Science One, unterhält gute Kontakte zu Facebook und Mark Zuckerberg.

Daneben ist der umtriebige Harvard-Professor selbst Unternehmer und hat mit Crimson Hexagon eine Firma gegründet, die ebenfalls, ähnlich wie Cambridge Analytica, im Jahr 2018 in einen Datenskandal verwickelt war.

Als die Verträge von Crimson Hexagon mit fragwürdigen Klienten in der Türkei und in Russland publik wurden, kappte Facebook vorübergehend Crimson Hexagon den Datenzugang. Noch im selben Jahr wurde die Firma an den Social-Media-Analysten Brandwatch verkauft, wo Gary King heute im Aufsichtsrat sitzt. Die Facebook-Daten an private Firmen fließen ungefiltert weiter.

Im FAQ-Teil der Webseite von Social Science One findet sich als allerletzte Frage des zweiten Fragenkatalogs ein Eintrag, in dem sich Gary King quasi selbst seine eigene Absolution erteilt und erklärt, dass es aufgrund seiner Tätigkeit für Hexagon/Brandwatch keinerlei Interessenkonflikt gebe.

Auf Nachfrage, inwieweit Facebook direkt oder indirekt geschäftliche Beziehungen zu Gary King unterhält, wollte sich Facebook nicht äußern.

Die offene Hintertür

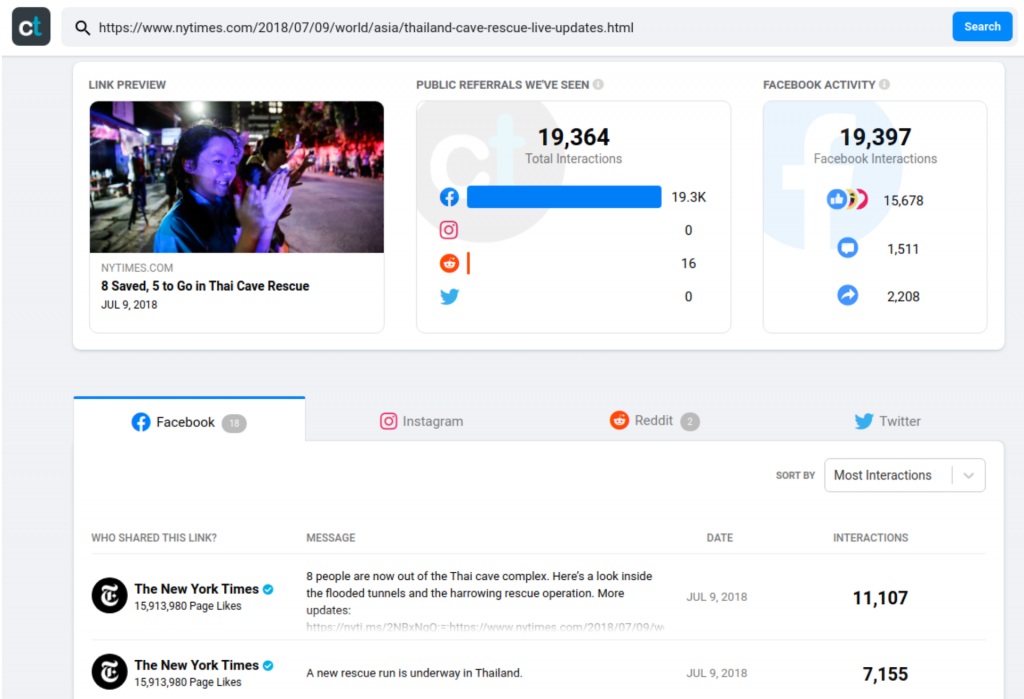

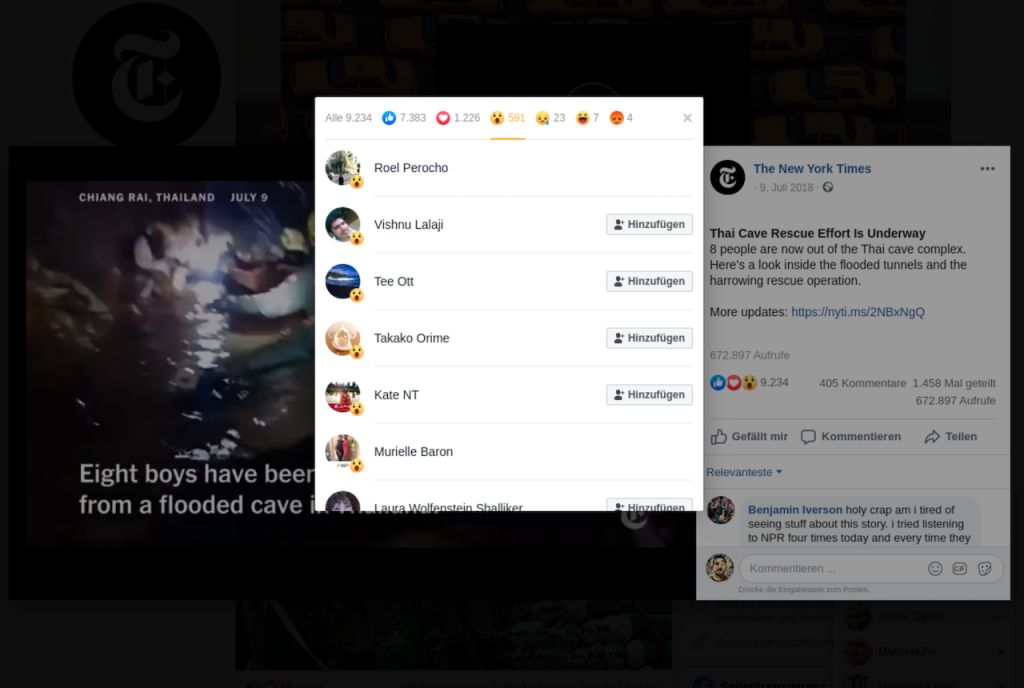

Mit Analyse-Tools, wie sie von Gary Kings Hexagon/Brandwatch oder von Facebook selbst angeboten werden, können Anzeigenkunden gezielt auf Kundenjagd gehen. Einige Forscher sind sogar dazu übergegangen, lieber mit diesen kommerziellen Tools zu arbeiten, weil die Daten hier oft ungeschützter sind, als alles, was den Wissenschaftlern für ihre Forschungsarbeit angeboten wird.

Wenn anonymisierte Daten zum Nutzer-Verhalten für handverlesene Wissenschaftler als problematisch eingestuft werden mit Verweis auf die EU-Datenschutzverordnung, dann müsse man gegenüber kommerziellen Anbietern genauso konsequent sein und Daten-Aggregatoren wie CrowdTangle oder Gary Kings Hexagon/Brandwatch mitsamt der zugrundeliegenden Graph API sofort abschalten, resümiert Hegelich.

„Welch Ironie!“, kommentiert der Software-Experte Paul Franics das Geschehen aus seinem Max-Planck-Institut für Softwaresysteme in Kaiserslautern. Jeder Anzeigenkunde habe einen besseren Zugang zu den Nutzer-Daten als die Wissenschaftler. Sein Fazit: „Facebook schützt die Vordertür wie verrückt, während die Hintertür weiterhin weit offen steht.“

Bewertung

Facebook (= Mark Zuckerberg) hat dazugelernt und viele Fehlentscheidungen der Vergangenheit korrigiert. Tatsächlich steckt das Unternehmen heute viel Geld in die Kuratierung der Inhalte, versucht die Verbreitung von Fake News und Propaganda auf den eigenen Plattformen zumindest einzudämmen.

Doch wie man am Beispiel Social Science One erkennen kann, hat sich am „System Facebook“ nichts geändert. Zuckerberg verspricht Politikern Aufklärung, gaukelt der Öffentlichkeit Unabhängigkeit vor, behält dabei aber immer im Hintergrund alle Fäden selbst in der Hand.

Wenn Zuckerberg heute in Berlin, Brüssel und Washington mehr staatliche Regulierung einfordert, so sollten Abgeordnete, Minister- und Kommissarinnen diese Selbstgeißelung als das erkennen, was sie ist: ein großer Bluff.

Lange haben Gesetzgeber, Datenschutzbehörden und Gerichte weggesehen, entweder, weil sie das eigentliche Problem nicht erkannt hatten, oder weil sie nicht über genug Manpower oder Expertise verfügten, um den Heerscharen aus Lobbyisten und Anwälten von Facebook oder Google etwas entgegenzusetzen. Doch genau das muss jetzt geschehen.

3 Fragen:

- Will man die Aufklärung darüber, wie Menschen vor demokratischen Wahlen manipuliert werden, wirklich einem Unternehmen wie Facebook überlassen?

- Sollen Datenmonopolisten selbst entscheiden dürfen, wann Datenschutzgesetze streng ausgelegt werden sollen und wann eher nicht?

- Soll Facebook die Regeln definieren, wie es sich selbst regulieren will?

–

Meinungen?